運用新型神經網路 小資料集也能訓練高效人工智慧模型

CTIMES/SmartAuto

2020-12-09 09:46:59

加入我的收藏

【CTIMES/SmartAuto 編輯部 報導】 2020年12月08日 星期二

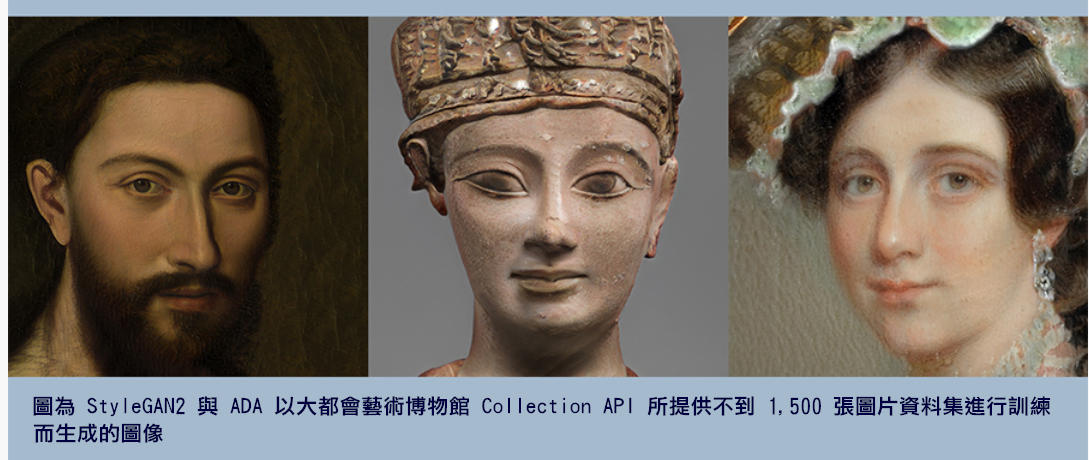

NVIDIA的研究人員把開創性的神經網路訓練技術用於熱門的 NVIDIA StyleGAN2模型上,以大都會藝術博物館所提供不到 1,500 張圖片這麼小的資料集,用新的角度去審視藝術品。他們用 NVIDIA DGX系統來加快訓練速度,取材自歷史人物肖像,創造出新的 AI 藝術。

這項稱為自我調整判別器增強 (adaptive discriminator augmentation; ADA) 的技術,將訓練所需的影像數量減少了 10 到 20 倍,卻依舊能獲得良好的訓練成果。

生成對抗網路跟大多數神經網路一樣,長期以來始終遵循一個基本原則,也就是訓練資料越多,模型品質越好。原因在於每個生成對抗網路都由兩個合作的網路組成,一個負責建立合成影像的生成器,還有一個根據訓練資料學習逼真影像外觀相似程度的判別器。

判別器對生成器進行指導,對它生成的每個像素給予回饋,以協助提高合成影像的真實感。然而可供學習的訓練資料有限,判別器無法幫助生成器徹底發揮其潛力,就像是一個新手教練所經歷過的比賽場次,比經驗豐富的專家少得多。

通常要用上五萬到十萬張影像,才能訓練出一個高品質的生成對抗網路。但在多數情況下,研究人員手邊根本沒有幾萬或幾十萬張樣本影像可供使用。

如果只用幾千張影像來進行訓練,許多生成對抗網路會無法產生出極具逼真感的影像。判別器只是單純記住訓練影像,無法提供有用的回饋給生成器時,就會出現這個稱為過度擬合 (overfitting) 的問題。

NVIDIA Research的ADA方法,能夠以自我調整的方式來增強資料,代表在訓練過程中不同的時間點調整資料增強量,以避免過度擬合。此舉讓 StyleGAN2 這樣的模型就算使用少一個數量級的訓練影像,也能達到同樣驚人的效果。

NVIDIA 繪圖研究部門副總裁 David Luebke 表示:「這些結果代表人們可以使用生成對抗網路來解決問題,這些問題不是得耗費大量時間來取得海量資料,不然就是難以取得這麼大量的資料。我迫不及待地想看看藝術家、醫學專家和研究人員,會把這項技術用在哪些領域。」

這項新方法是NVIDIA研究人員在生成對抗網路創新傳統中的最新成果,這些研究人員開發出突破性的生成對抗網路模型,像是 AI 繪畫應用程式 GauGAN、遊戲引擎模仿程式 GameGAN 及寵物照片變臉程式 GANimal。這些應用程式可以在 NVIDIA AI Playground 上取得。

原文連結》http://www.ctimes.com.tw/DispNews/tw/神經網路/NVIDIA/2012081404ZF.shtml

NVIDIA的研究人員把開創性的神經網路訓練技術用於熱門的 NVIDIA StyleGAN2模型上,以大都會藝術博物館所提供不到 1,500 張圖片這麼小的資料集,用新的角度去審視藝術品。他們用 NVIDIA DGX系統來加快訓練速度,取材自歷史人物肖像,創造出新的 AI 藝術。

這項稱為自我調整判別器增強 (adaptive discriminator augmentation; ADA) 的技術,將訓練所需的影像數量減少了 10 到 20 倍,卻依舊能獲得良好的訓練成果。

生成對抗網路跟大多數神經網路一樣,長期以來始終遵循一個基本原則,也就是訓練資料越多,模型品質越好。原因在於每個生成對抗網路都由兩個合作的網路組成,一個負責建立合成影像的生成器,還有一個根據訓練資料學習逼真影像外觀相似程度的判別器。

判別器對生成器進行指導,對它生成的每個像素給予回饋,以協助提高合成影像的真實感。然而可供學習的訓練資料有限,判別器無法幫助生成器徹底發揮其潛力,就像是一個新手教練所經歷過的比賽場次,比經驗豐富的專家少得多。

通常要用上五萬到十萬張影像,才能訓練出一個高品質的生成對抗網路。但在多數情況下,研究人員手邊根本沒有幾萬或幾十萬張樣本影像可供使用。

如果只用幾千張影像來進行訓練,許多生成對抗網路會無法產生出極具逼真感的影像。判別器只是單純記住訓練影像,無法提供有用的回饋給生成器時,就會出現這個稱為過度擬合 (overfitting) 的問題。

NVIDIA Research的ADA方法,能夠以自我調整的方式來增強資料,代表在訓練過程中不同的時間點調整資料增強量,以避免過度擬合。此舉讓 StyleGAN2 這樣的模型就算使用少一個數量級的訓練影像,也能達到同樣驚人的效果。

NVIDIA 繪圖研究部門副總裁 David Luebke 表示:「這些結果代表人們可以使用生成對抗網路來解決問題,這些問題不是得耗費大量時間來取得海量資料,不然就是難以取得這麼大量的資料。我迫不及待地想看看藝術家、醫學專家和研究人員,會把這項技術用在哪些領域。」

這項新方法是NVIDIA研究人員在生成對抗網路創新傳統中的最新成果,這些研究人員開發出突破性的生成對抗網路模型,像是 AI 繪畫應用程式 GauGAN、遊戲引擎模仿程式 GameGAN 及寵物照片變臉程式 GANimal。這些應用程式可以在 NVIDIA AI Playground 上取得。

原文連結》http://www.ctimes.com.tw/DispNews/tw/神經網路/NVIDIA/2012081404ZF.shtml

01/28【智慧製造】夾治具設計應用實務培訓班(台中)

01/28【智慧製造】夾治具設計應用實務培訓班(台中)

經濟部拿下R&D100 2025 7項大獎 連續18年獲獎數破百 臺灣科研實力深具國際競爭力

經濟部拿下R&D100 2025 7項大獎 連續18年獲獎數破百 臺灣科研實力深具國際競爭力